分析算法使用说明

1. 简介:

在寄云应用开发与数据分析平台中提供了一些常见的分析算法,供用户参考及使用,目前提供的算法除了一些Spark提供的常用分析算法外,还增加了部分针对工业大数据分析领域常用的分析算法,以及一些根据工业大数据分析领域需求对原有Spark增强的一些算法。这些算法主要包括:

基本统计

基于固定时间窗口的min, max, average值统计

假设检验

最大似然期望(MLE)

广义似然比(GLR)

相关性(Correlation)

多维相关性(CorrelationMatrix)

规范化(Normalization)

时序分析

时序计算

时序模型(内存版)

Sessionize

聚类 (Clustering)

Kmeans (轮廓系数)

层次聚类

高斯混合

回归(Regression)

线性回归

高斯过程回归

过滤 (Filtering)

白化

关联规则(Association)

FPGrowth

SPath

Spath

2. 版本:

当前订阅的分析算法版本:1.0

3. Spark服务准备:

在寄云应用开发与数据分析平台上提供的分析算法是需要本平台的Spark大数据服务支撑的,在使用这些分析算法之前,需要成功订阅Spark大数据服务,具体订阅操作详见Spark服务使用说明。

4. 算法使用说明:

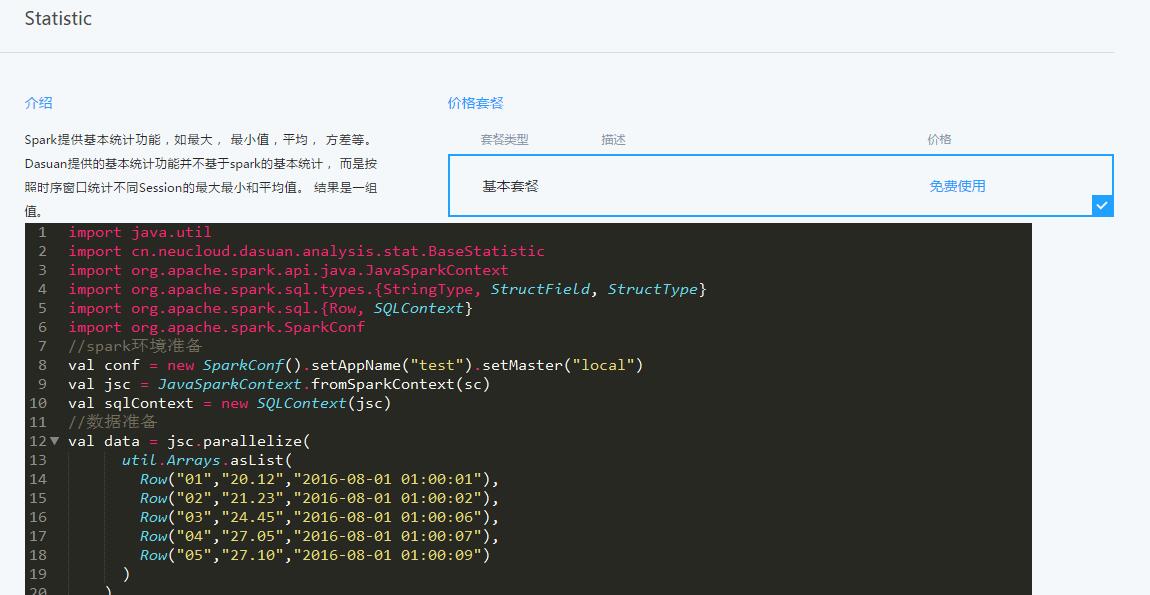

1 参考寄云应用开发与数据分析平台使用手册进入到分析目录的算法项下,即可看到可以提供的分析算法,点击算法名称后,在介绍部分即可看到该算法的示例代码。

2 目前提供的分析算法示例代码可以在GitHub获取(https://github.com/neucloud/spark-demo.git),以下步骤将以基本统计算法为例说明其如何使用。

3 在GitHub上获取基本统计(Statistic)算法示例代码。

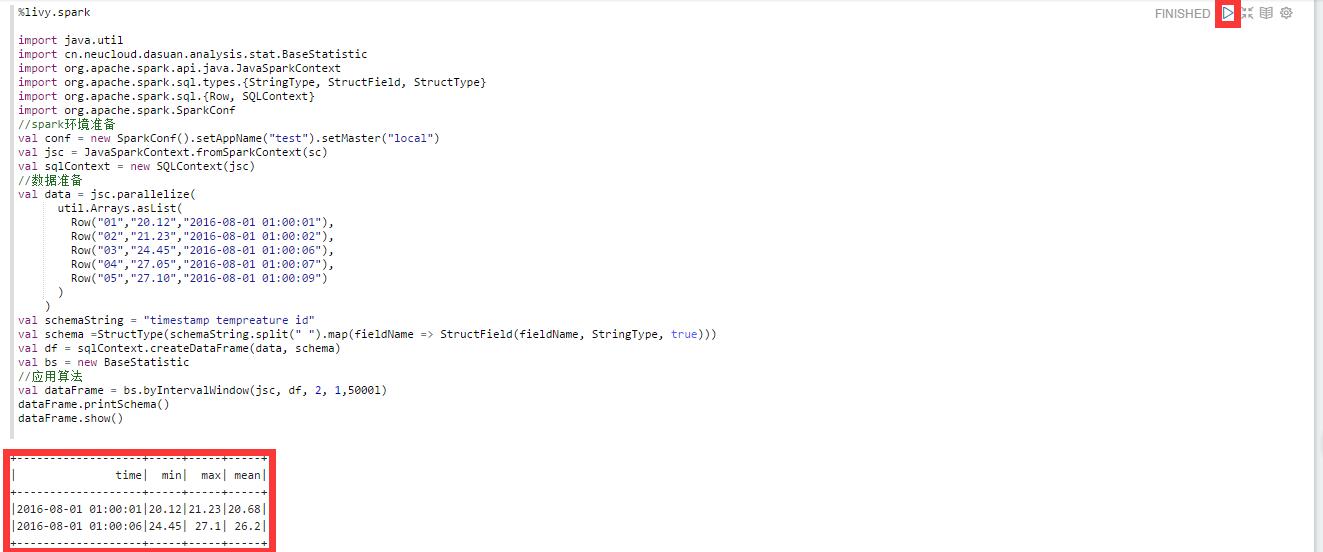

%livy.spark

//算法名称-基本统计

import java.util

import cn.neucloud.dasuan.analysis.stat.BaseStatistic

import org.apache.spark.api.java.JavaSparkContext

import org.apache.spark.sql.types.{StringType, StructField, StructType}

import org.apache.spark.sql.{Row, SQLContext}

import org.apache.spark.SparkConf

//spark环境准备

val conf = new SparkConf().setAppName("test").setMaster("local")

val jsc = JavaSparkContext.fromSparkContext(sc)

val sqlContext = new SQLContext(jsc)

//数据准备

val data = jsc.parallelize(

util.Arrays.asList(

Row("01","20.12","2016-08-01 01:00:01"),

Row("02","21.23","2016-08-01 01:00:02"),

Row("03","24.45","2016-08-01 01:00:06"),

Row("04","27.05","2016-08-01 01:00:07"),

Row("05","27.10","2016-08-01 01:00:09")

)

)

val schemaString = "timestamp tempreature id"

val schema =StructType(schemaString.split(" ").map(fieldName => StructField(fieldName, StringType, true)))

val df = sqlContext.createDataFrame(data, schema)

val bs = new BaseStatistic

//应用算法,参数:数据对象:df, 时间列:2, 所需求值的列:1, 时间窗口:5000l为5000毫秒

val dataFrame = bs.byIntervalWindow(jsc, df, 2, 1,5000l)

dataFrame.printSchema()

dataFrame.show()

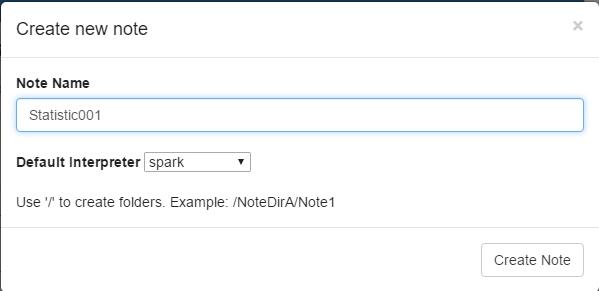

4 进入之前订阅的Spark大数据服务的Zeppelin界面,新建一个NoteBook。

5 将第3步得到的代码复制到这个NoteBook中,之后选择代码右上角的执行按键,即可得到处理结果。